クラウドネイティブな開発が主流となるなか、複数のコンテナを効率的に管理・運用するための技術として注目されているのがKubernetesです。Dockerでコンテナ化したアプリケーションを本番環境で運用する際、手動での管理には限界があります。Kubernetesは、自動スケーリングや自己修復機能により、複雑なコンテナ運用を自動化し、システムの可用性を高めます。

本記事では、Kubernetesの基本概念から仕組み、導入メリット・デメリット、具体的な導入ステップまで、初心者にもわかりやすく解説します。

さくらインターネットが提供している高火力シリーズ「PHY」「VRT」「DOK」を横断的に紹介する資料です。お客様の課題に合わせて最適なサービスを選んでいただけるよう、それぞれのサービスの特色の紹介や、比較表を掲載しています。

1.Kubernetes(K8s)とは

Kubernetesは、コンテナ化されたアプリケーションのデプロイ、スケーリング、管理を自動化するオープンソースのプラットフォームです。Googleが社内で利用していたシステムの知見をもとに開発され、2014年にオープンソースとして公開されました。現在は世界中の開発者により活発に開発が進められており、事実上の業界標準となっています。

1-1.Kubernetesの定義とK8sの由来

コンテナオーケストレーションツールとしての定義

Kubernetesは「コンテナオーケストレーションツール」として分類されます。具体的には、コンテナの起動・停止、リソースの割り当て、ネットワーク設定、障害時の自動復旧などを自動的に行います。これにより、数十から数百のコンテナを効率的に管理できるようになります。

名前の意味と略称(K8s)

Kubernetesという名前は、ギリシャ語で「舵取り」や「操舵手」を意味する言葉に由来しています。コンテナという船を適切に導く役割を表しています。略称のK8sは、Kとsの間に「ubernete」という8文字があることから生まれました。技術文書やコミュニティでは、この略称が頻繁に使われており、読み方は「ケーエイツ」または「ケーエイトエス」といった呼び方があります。

1-2.DockerとKubernetesの違い

DockerとKubernetesは役割が異なります。Dockerはコンテナの作成・実行を担当し、Kubernetesは複数コンテナの管理・運用を担当します。

Dockerの役割

Dockerは、アプリケーションとその実行環境を「コンテナ」という単位でパッケージ化する技術です。コンテナは仮想マシンよりも軽量で起動が速く、開発環境と本番環境の差異を解消できます。

Kubernetesの役割

Kubernetesは、Dockerなどで作成したコンテナイメージを本番環境で運用する際に必要となる、たとえば自動スケーリング、負荷分散、障害時の自動復旧といった機能を実現します。つまり、Dockerが「コンテナを作る」技術であるのに対し、Kubernetesは「コンテナを運用する」技術です。

Kubernetesは初心者でも使えるのか

Kubernetesは概念が複雑で、学習コストが高いのが実情です。YAML形式の設定ファイルの記述や、クラスタ・ノード・Podといった階層構造の理解が必要になります。

しかし、MinikubeやKindといったローカル環境での学習ツールや、マネージドKubernetesサービス(Google Kubernetes Engine、Amazon EKS、Azure AKSなど)を活用することで、初心者でも段階的に習得できます。

2.Kubernetesが解決する課題

本番環境で複数のコンテナを運用する際、さまざまな課題が発生します。ここでは、Kubernetesがどのような課題を解決するのかを見ていきましょう。

2-1.手動管理の限界とヒューマンエラーリスク

本番環境で複数のコンテナを手動で管理する場合、アクセス増加に応じたスケーリング、各コンテナの設定の統一、障害発生時の監視と対応など、運用負担が急激に増大します。

特にマイクロサービスアーキテクチャ(アプリケーションを小さな独立したサービスに分割する設計手法)では、数十から数百のコンテナが稼働するため、手動管理は現実的ではありません。障害発生時の手動対応では、対応の遅れやヒューマンエラーが発生しやすくなります。

Kubernetesを導入すると、これらの課題の多くを自動化により大幅に軽減できます。

アクセス増加時は自動的にコンテナを増やし、障害発生時は自動検知・再起動を行います。設定は宣言的に統一管理できるため、運用者は個々のコンテナ操作から解放され、システム全体の設計に集中できます。

2-2.宣言的管理による運用の自動化

Kubernetesの大きな特徴のひとつが「宣言的管理」です。これは、従来の「手続き型」の管理方法とは根本的に異なるアプローチです。

従来のシェルスクリプトでは、「コンテナAを起動して、次にコンテナBを起動して…」という手順を記述する必要がありました。一方、Kubernetesでは、「コンテナを3つ起動してほしい」「メモリは2GBを割り当ててほしい」といった最終的に実現したい状態をYAML形式で宣言するだけで済みます。実際の起動・配置・監視といった処理は、Kubernetesが自動で行います。

2-3.自動スケーリング・自己修復・ロードバランシング

Kubernetesには、運用を大幅に効率化する3つの重要な機能があり、これらが連携することで安定したサービスを提供しています。

自動スケーリング

トラフィック増加時には自動的にコンテナを増やし、減少時には削減する機能です。ECサイトのセール時やニュースサイトでバズが発生した際など、急激なアクセス増加にも柔軟に対応できます。

自己修復機能

障害が発生したコンテナを自動的に再起動します。ノード(サーバー)自体に障害が発生した場合も、別の正常なノードにコンテナを自動的に移動させます。人間の介入なしにシステムが自ら回復するため、サービスの継続性が大幅に向上します。

ロードバランシング機能

複数のコンテナに均等にトラフィックを分散します。特定のコンテナに負荷が集中することを防ぎ、システム全体のパフォーマンスを最適化できます。

2-4.マイクロサービス・CI/CDとの相性

Kubernetesは、マイクロサービスアーキテクチャやCI/CD(継続的インテグレーション・継続的デリバリー)との相性が良く、継続的なデプロイと更新を効率化できます。ローリングアップデート機能により、一部のサービスだけを更新しながら、他のサービスは動作を継続できます。

3.Kubernetesの仕組みと構成要素

Kubernetesがどのような構造で動作し、どのようにコンテナを管理しているのかを理解することで、導入時のイメージが明確になります。ここでは、Kubernetesの基本的な仕組みと構成要素を解説します。

3-1.Kubernetesの階層構造とオーケストレーション

クラスタ全体像

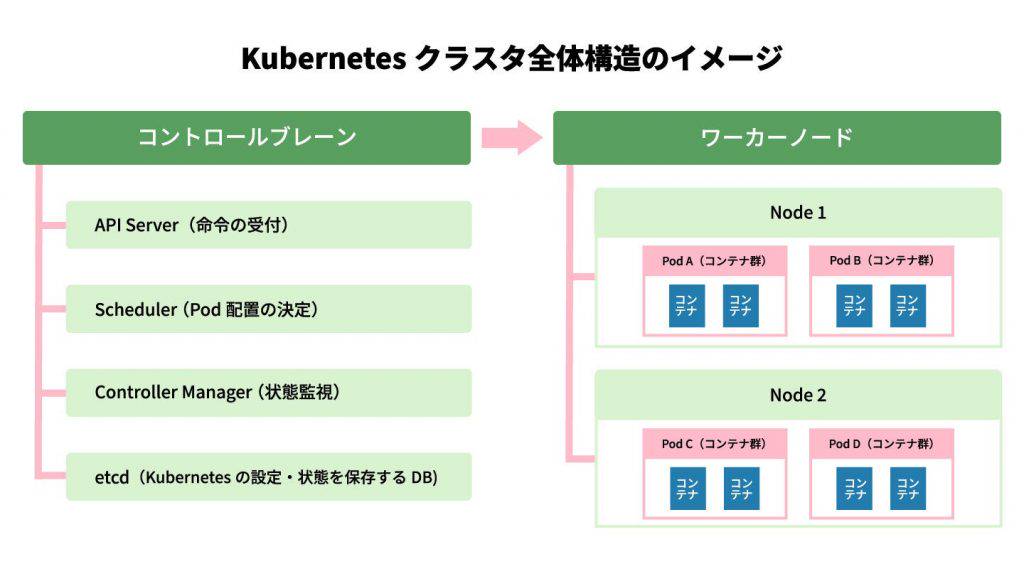

Kubernetesクラスタは、「コントロールプレーン」(クラスタ全体を管理する司令塔)と「ワーカーノード」(実際にコンテナを動かすサーバー)に分かれます。

コントロールプレーンは、以下のコンポーネントで構成されます。

- API Server:すべての操作の窓口

- Scheduler:新しいPodをどのノードに配置するかを決定する

- Controller Manager:クラスタの状態を監視・調整する

この構成により、コントロールプレーンで一時的に障害が発生しても、短時間であればワーカーノード上の既存アプリケーションは動作を継続できます(ただし、その間は新規デプロイやスケール変更などの制御は行えません)。また、ワーカーノードを追加することで、処理能力を柔軟に拡張できる仕組みになっています。

ノード → Pod → コンテナの関係性

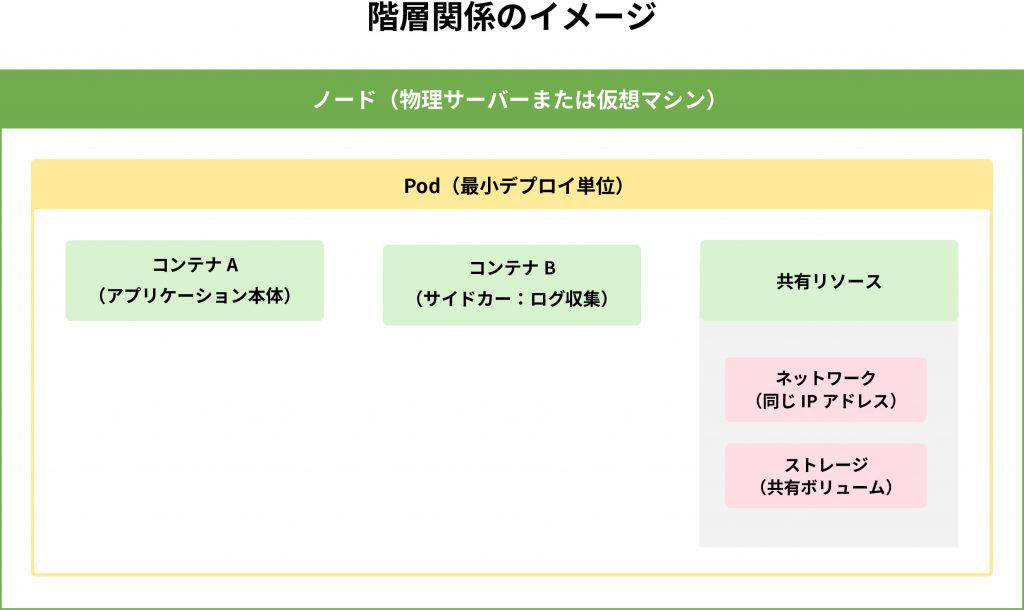

Kubernetesでは、ノード(物理サーバーまたは仮想マシン)の上にPod(ポッド)が配置され、その中でコンテナが動作します。

Podは、1つ以上のコンテナをグループ化したもので、同じPod内のコンテナは同じネットワークとストレージを共有します。密接に連携する複数のコンテナを一体として管理するため、Podという単位が必要です。

Podは、密接に連携する複数のコンテナをまとめて管理するために用いられます。

たとえば、Webサーバーとログ収集エージェントは常に一緒に動作する必要があります。Podという単位でまとめることで、一緒にスケジューリングされ、一緒にスケールし、一緒に削除することが保証されます。

Service・Deployment・Namespaceの役割

Kubernetesでコンテナを効率的に運用するには、Service、Deployment、Namespaceという3つの重要な概念を理解する必要があります。

Service(サービス)

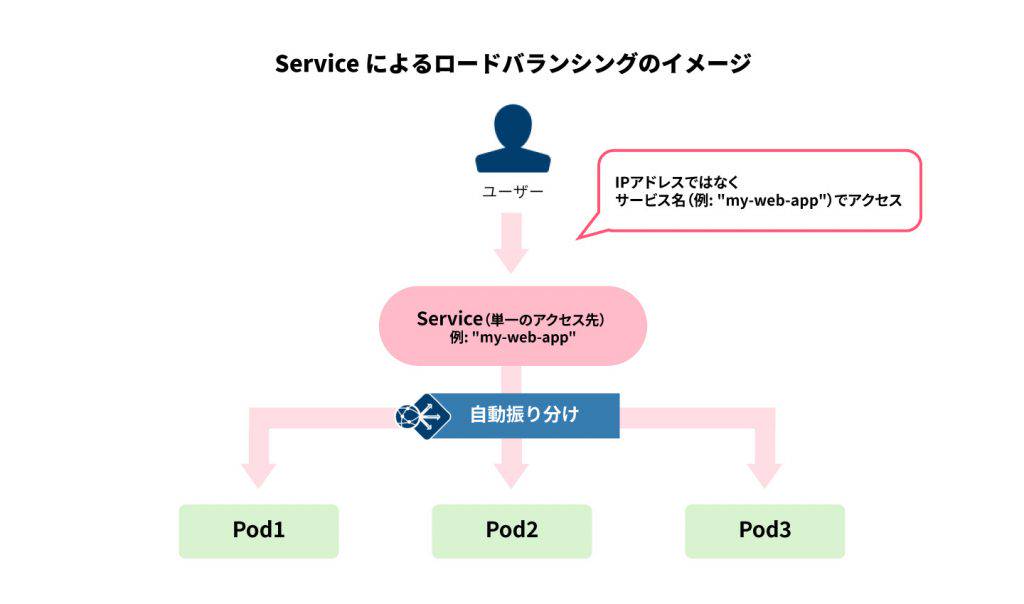

Serviceは、複数のPodへのアクセス窓口を提供します。たとえば、同じWebアプリケーションの Pod が3つ稼働している場合(1つのアプリケーションを3つに複製して負荷分散)、Serviceが自動的にトラフィックを3つに振り分けます(ロードバランシング)。Podが増減しても、アクセス先は「Serviceの名前」だけで済むため、管理が簡単です。

※「my-web-app」はServiceの名前です。アプリケーションは「my-web-app」という名前でアクセスするだけで、自動的に3つのPodに振り分けられます。

Deployment(デプロイメント)

Deploymentは、Podの数や更新方法を管理します。

Kubernetesでは、同じアプリケーションのPodを複数動かして負荷を分散させることができます。これらの複数のPodを「複製(レプリカ)」と呼びます。

たとえば、「このアプリのPodを常に3つ動かしておく」と宣言すると、障害で1つ停止しても自動的に新しいPodを起動して3つに戻します。新バージョンへの更新時も、1つずつ順番に入れ替える「ローリングアップデート」により、サービス停止なしで更新できます。

Namespace(ネームスペース)

Namespaceは、1つのクラスタを複数の領域に分割する仕組みです。「開発環境」「検証環境」「本番環境」をそれぞれ別のNamespaceに分けることで、リソースの管理や権限の分離が容易になります。

リソースとスケジューリングの自動管理

Kubernetesのスケジューラは、各ノードのリソース(CPU、メモリ)の使用状況を常に監視しています。新しいPodを配置する際、最適なノードを自動的に選択します。

たとえば、新しいPodが2GBのメモリを必要とする場合、スケジューラは各ノードの空きメモリを確認し、十分な余裕があるノードにPodを配置します。リソースが不足している場合は、Podの起動を待機させるか、優先度の低いPodを終了させて空きを作ります。

この自動配置により、人間が個々のサーバーのリソース状況を把握して手動で配置する必要がなくなります。クラスタ全体のリソースを効率的に活用できるのです。

ネットワーク管理とサービスディスカバリ

Kubernetesは、Pod間の通信を自動的に管理します。各Podには一意のIPアドレスが割り当てられ、クラスタ内のどのPodからでも、他のPodに直接通信できます。これは「フラットなネットワーク」と呼ばれる構造です。

ただし、PodのIPアドレスは再起動のたびに変わるため、直接IPアドレスで通信するのは非推奨です。そのため、サービスディスカバリ機能(サービス名でアクセス先を自動的に発見する仕組み)により、サービス名でPodにアクセスする方法が推奨されます。Podが再起動してIPアドレスが変わっても、サービス名は変わらないため、アプリケーション側の設定変更は不要です。

4.Kubernetesのメリット・デメリットと導入判断

Kubernetes導入を検討する際は、メリットとデメリットを正しく理解し、自社のシステム要件に合致するかを判断することが重要です。

4-1.Kubernetes導入による5つのメリット

宣言的管理による運用の効率化

Kubernetesでは、「あるべき状態」をYAML形式で宣言するだけで、実際の状態を自動的に調整します。この宣言的管理により、設定をコード化してGitなどで管理できるため、バージョン管理やレビューが容易になります。

これは「Infrastructure as Code(IaC)」と呼ばれる手法で、設定の変更履歴がすべて残り、問題があれば過去のバージョンに戻すことも簡単です。また、同じ設定ファイルで開発環境と本番環境の同じ構成を再現でき、環境差異によるトラブルを減らせます。チーム全体で設定を共有し、レビューしながら改善していく文化が生まれます。

自動スケーリングによる柔軟なリソース管理

Kubernetesの自動スケーリング機能(Horizontal Pod Autoscaler)は、CPU使用率やメモリ使用量などに基づいて、Podの数を自動的に増減させます。ECサイトでセール時にアクセスが急増した場合、自動的にコンテナを増やして対応し、終了後は削減してコストを最適化できます。

自己修復機能による高可用性の実現

Kubernetesは、Podの健全性を常に監視し、異常を検知すると自動的に再起動します(セルフヒーリング)。

ノード(サーバー)障害が発生した場合も、別の正常なノードにPodを自動的に移動させます。たとえば、ハードウェア障害でサーバー1台が停止しても、そのサーバー上で動いていたPodは他のサーバーで自動的に起動されます。

マルチクラウド・ハイブリッド環境対応

AWS、Azure、Google Cloudなど複数のクラウドで共通のKubernetes APIとマニフェストを利用できるため、環境移行を比較的容易にし、ベンダーロックイン(特定ベンダーの製品に依存し、他への移行が困難になる状態)のリスクを軽減できます。

また、オンプレミスとクラウドを組み合わせたハイブリッド環境にも対応できます。

デプロイの自動化と無停止更新

Kubernetesのローリングアップデート機能を使えば、サービスを停止せずにアプリケーションを更新できます。新バージョンを段階的にデプロイ(新旧2つの環境を用意し、瞬時に切り替える手法)し、問題があれば自動的にロールバックします。Blue-Greenデプロイやカナリアデプロイ(一部のユーザーにのみ新バージョンを提供してテストする手法)といった高度な戦略も実現できます。

4-2.導入・運用時の注意点

学習コストの高さ(YAML、概念の複雑さ)

Kubernetesは、クラスタ、ノード、Pod、Service、Deploymentなど、多くの概念を理解する必要があります。YAML形式の設定ファイルの記述にも慣れが必要です。チーム全体で学習時間を確保し、段階的に習得していくことが重要です。

初期構築と継続的な運用の負担

Kubernetesクラスタを自前で構築・運用する場合、初期構築の手間に加え、セキュリティパッチの適用、バージョンアップ、監視・ログ管理などの継続的な運用が必要です。小規模なシステムでは、運用コストがメリットを上回る可能性があります。この場合、マネージドKubernetesサービス(Google Kubernetes Engine、Amazon EKS、Azure AKSなど)の利用を検討すべきです。マネージドサービスでは、コントロールプレーンの管理をクラウドベンダーに任せられるため、運用負担を大幅に削減できます。

4-3.Kubernetesを導入すべきケース

Kubernetesは、次のような場面で特に力を発揮します。

- マイクロサービスアーキテクチャで多数のコンテナを運用する場合

- トラフィックの変動が大きく自動スケーリングが必要な場合

- 高可用性が求められるミッションクリティカルなシステム

- マルチクラウド・ハイブリッド環境で運用する場合

- CI/CDを活用した高頻度なデプロイを実現したい場合

- GPUリソースを効率的に管理したい場合

一方、以下のような場面では、導入は慎重に検討すべきです。

- シンプルな単一アプリケーションで、スケーリングの必要性が低い場合

- チームにKubernetesの知識がなく、学習時間を確保できない場合

- 小規模なシステムで、運用コストがメリットを上回る場合

こうした場合は、Docker SwarmやNomad、AWS FargateやGoogle Cloud Runのようなマネージドなコンテナホスティングサービスの利用も検討するとよいでしょう。

5.Kubernetes導入の進め方

Kubernetesの導入は、学習から本番運用まで段階的に進めることが重要です。

5-1.Kubernetes導入の3ステップ

ステップ1:ローカル環境での学習

Kubernetesを学習する最初のステップは、ローカル環境でクラスタを構築し、基本的な操作を習得することです。Minikubeは、1ノードのKubernetesクラスタをローカルマシン上に構築できるツールです。Kindは、Dockerコンテナ内でKubernetesクラスタを動かすツールで、複数ノードの構成も試せます。

これらのツールで、Podの作成とデプロイ、Serviceの作成とアクセス確認、Deploymentによるスケーリング、ローリングアップデートとロールバックなどの基本操作を習得しましょう。

ステップ2:クラウド環境での本格運用

本番環境では、マネージドKubernetesサービスの利用がおすすめです。Google Kubernetes Engine(GKE)、Amazon Elastic Kubernetes Service(EKS)、Azure Kubernetes Service(AKS)などがあります。マネージドサービスを使えば、コントロールプレーンの管理をクラウドベンダーに任せられるため、運用負担を大幅に削減できます。

ステップ3:運用フェーズの設計

本格運用では、監視とログ管理の仕組みが欠かせません。Prometheus(メトリクス収集)とGrafana(可視化)で監視を、Fluentd(ログ収集)とElasticsearch(ログ保存・検索)でログ管理を整備しましょう。また、GitOps(ArgoCD、Flux)やCI/CDツール(Jenkins、GitLab CI)との連携により、デプロイの自動化を進めることが重要です。

5-2. AI・機械学習ワークロードでの活用可能性

補足として、Kubernetesは汎用的なコンテナオーケストレーションツールですが、AI・機械学習のワークロードでも効果的に活用できます。大量のデータ処理や学習ジョブを実行する際、GPUリソースの自動割り当て、複数の学習ジョブの並列実行、学習完了後のリソース自動解放などを実現できます。

高性能なGPUリソースが必要な場合は、さくらインターネットの高火力シリーズなど、専用のインフラサービスとKubernetesを組み合わせることで、効率的なAI開発環境を構築できます。

まとめ

Kubernetesは、コンテナ化されたアプリケーションを効率的に管理・運用するための強力なプラットフォームです。自動スケーリング、自己修復、宣言的管理、マルチクラウド対応といった機能により、システムの可用性を高め、運用負担を削減できます。

特に、マイクロサービスアーキテクチャを採用する企業や、トラフィックの変動が大きいサービス、高可用性が求められるシステムにおいて大きな価値を発揮します。CI/CDパイプラインと組み合わせることで、継続的なデリバリーを実現し、ビジネスのスピードを加速することも可能です。ただし、学習コストや運用負担も考慮し、自社のシステム規模や要件に応じて導入を判断することが重要です。

Kubernetesの導入は、ローカル環境での学習から始め、段階的に本番運用に移行していくアプローチが効果的です。さくらインターネットでは、Kubernetesクラスタを構築できるさまざまなクラウドインフラを提供しています。通常のサーバーでの運用はもちろん、AI・機械学習など高性能なGPUリソースが必要な場合は、高火力シリーズと組み合わせることで、最先端の開発環境を構築できます。

Kubernetesを活用したシステム構築をご検討中の方は、ぜひご相談ください。

さくらインターネットが提供している高火力シリーズ「PHY」「VRT」「DOK」を横断的に紹介する資料です。お客様の課題に合わせて最適なサービスを選んでいただけるよう、それぞれのサービスの特色の紹介や、比較表を掲載しています。

New

New

New

New

New

New

特集

特集