IT・デジタル関連の最新情報や企業事例をいち早くキャッチ

>>さくマガのメールマガジンに登録する

近年、ChatGPTを筆頭に生成AIサービスが世界的に普及し、個人での利用だけでなく、ビジネスシーンでの活用も急速に広がっています。これらのAIサービスの基盤となっているのが、大規模言語モデル(LLM:Large Language Models)です。LLMは、膨大なテキストデータとディープラーニング技術を用いて構築された革新的な自然言語処理モデルであり、自然な対話や文章生成を可能にしています。

本記事では、LLMの基本的な仕組みから、従来の言語モデルとの違い、具体的な活用事例まで、体系的に解説します。生成AIサービスを効果的に活用するために必要な知識を、技術的な側面と実用的な観点の両方からご説明します。この記事が、LLMの全体像を把握し、ビジネスや日常生活での活用方法について理解を深める一助となれば幸いです。

さくらインターネットが提供している高火力シリーズ「PHY」「VRT」「DOK」を横断的に紹介する資料です。お客様の課題に合わせて最適なサービスを選んでいただけるよう、それぞれのサービスの特色の紹介や、比較表を掲載しています。

LLM(大規模言語モデル)とは

LLM(大規模言語モデル)とは生成AIモデルの一種で、従来の言語モデルと比較して、「データ量」「計算量」「パラメータ量」という3つの要素が大幅に強化された、革新的な自然言語処理技術です。

まず「データ量」については、インターネット上の膨大なテキストデータを学習データとして使用しています。これにより、幅広い知識と文脈理解が可能となりました。「計算量」においては、高性能なGPUを活用することで、複雑な言語処理タスクをリアルタイムで実行できるまでに向上しています。そして「パラメータ量」については、量が多ければ多いほど、より繊細な言語処理と生成を実現しています。

LLMは文章生成や要約、翻訳、質問応答など、さまざまな言語処理タスクを高い精度で実行できます。具体的な活用例として、たとえばビジネス文書の作成支援や多言語コミュニケーション、カスタマーサポートの自動化などがあります。

なおLLMのおもな基盤は、2017年に発表された「Transformer」というディープラーニングモデルです。Transformerは、入力されたテキストの文脈を効率的に学習し、より自然な言語処理を可能にする画期的な技術でした。この技術革新により、ChatGPTやBERTなど、現代の主要な言語モデルが実現されました。

このように、LLMは単なる言語処理ツールではなく、大量のテキストデータを学習し、複雑な言語パターンをを捉えることで、より自然なコミュニケーションを可能にする革新的な技術として、今後のAI発展の中核を担っています。

AI・ディープラーニングに最適な高火力GPUサーバー

>>サービスの詳細を見る

LLM(大規模言語モデル)の仕組み

LLM(大規模言語モデル)は、人間の言語を解析し生成するために、5つのステップを経て処理をおこないます。これらのステップは、入力されたテキストを段階的に処理し、最終的に人間が理解できる自然な文章として出力するまでの一連の流れを形成しています。具体的には、以下の5つのステップで処理が進められます。

- テキストデータのトークン化

- トークン化したデータの数値変換

- ニューラルネットワークによるデータの調整

- 文脈(コンテキスト)の把握

- 自然なテキストデータへの変換(デコード)

これらの処理の基盤となっているのが、前述した「Transformer」のディープラーニングモデルです。Transformerは、従来の技術と比べて処理を大幅に簡易化し、より迅速で高精度な言語処理を可能にしました。現代のLLMの急速な進化は、このTransformerの革新的な仕組みに支えられています。

①テキストデータのトークン化

テキストデータのトークン化は、人間の言葉をコンピューターが処理できる形に変換する最初の重要なステップです。

トークン化では、入力された文章を最小単位である「トークン」に分割します。たとえば英語の場合、単語や句読点がトークンとなりますが、日本語の場合は文字単位や形態素(意味を持つ最小単位)でトークン化されます。「私は学生です」という文章は、「私」「は」「学生」「です」というトークンに分割されます。

このプロセスが重要な理由は、コンピューターがテキストを効率的に処理するために、一定の大きさの単位に分割する必要があるためです。適切なトークン化により、後続の自然言語処理タスクにおける、単語の頻度計算、文脈の把握、機械翻訳などの精度が大きく向上し、より自然な言語処理が可能となるため、不可欠な前処理だといえるでしょう。

②トークン化したデータの数値変換

トークン化されたデータは、次にコンピューターが計算できる形式である数値ベクトルに変換されます。この過程は「ベクトル化」あるいは「エンコード」と呼ばれ、LLMの言語処理において核心的な役割を果たします。

ベクトル化では、各トークンに対して固有の数値の組み合わせ(ベクトル)が割り当てられます。たとえば「犬」というトークンは、数百次元(モデルによっては数千次元~数万次元)の数値の配列として表現されます。この数値には、そのトークンの意味的な特徴や他の単語との関係性が数学的に符号化されています。

この変換により、似た意味を持つ単語は似たベクトル表現を持つようになり、「犬」と「猫」は似たベクトルを持ちますが、「犬」と「車」は異なるベクトルを持つといった具合です。これによって、コンピュータは単語間の意味的な類似性や関係性を数学的に分類し、文章の意味をベクトル空間上で表現できるようになります。ベクトルそのものに具体的な意味があるわけではなく、単語間の関係性を数値で表現したものなのです。

③ニューラルネットワークによるデータの変換と特徴抽出

ニューラルネットワークによるデータの変換と特徴抽出は、LLMが言語を処理するための中核的なプロセスです。

このステップでは、多層構造を持つニューラルネットワークが、入力されたベクトルデータを段階的に変換し、文脈や関係性を考慮した特徴表現を抽出していきます。各層では、単語の出現確率だけでなく、単語間の関係性や文脈も考慮した複雑な計算がおこなわれます。たとえば「バッテリー」という単語が出現した場合、モデルは単語埋め込み表現(embedding)を用いて、前後の文脈を考慮しながら「スマートフォンの部品」なのか「野球の投手と捕手のコンビ」なのかを判断できるように学習していきます。

この過程で、モデルは大量の学習データから言語の統計的特徴、構文的な規則性、さらには意味的なパターンを抽出し、より自然な言語解析と生成が可能になっていきます。入力された情報は何度も変換・調整されます。

④文脈(コンテキスト)の理解

文脈理解は、LLMが単なる単語やフレーズの統計的処理に留まらず、文章全体の意味を正確に把握するための重要な機能です。

このステップでは、入力されたテキストの文脈や背景を考慮し、単語やフレーズの意味をより深く解釈します。たとえば「彼は背が高い」という文章の後に「バスケットボール選手です」という文が続く場合、LLMは「背が高い」の基準が一般的な平均身長よりもさらに上であることと解釈します。

また、同音異義語の処理にも文脈理解は不可欠です。「私は橋を渡った」という文章では、モデルは前後の文脈や単語の使用例を考慮し、「橋」が「箸」ではなく「道路を支える構造物」であることを判断できます。このように、文脈理解によってLLMは自然な応答能力を実現しています。

⑤自然なテキストデータへの変換(デコード)

デコードは、LLMの処理における最終段階で、内部で計算された結果を人間が理解できる自然な文章に変換するプロセスです。

この工程では、モデル内部の数値データ(ベクトル)を、最も適切な単語やフレーズに変換し、自然な文章を生成します。まずシステムは各単語の出現確率を計算し、Greedy Search(貪欲法)やBeam Search(ビームサーチ)、Samplingなどのデコーディング手法を用いて、文脈に最も適した単語を選択をおこないます。たとえば「今日の天気は」という入力に対して、「晴れです」「雨です」「曇りで少し寒いです」など、学習データの統計に基づいて適切な文章が生成されます。

また、文法的な正確さや自然な表現を保つため、文法チェックや意味の整合性などを確認し、必要があれば文章を追加する調整もおこなわれます。これにより、人間が書いたような自然で流暢な文章が生成されます。このプロセスでは、単に単語を並べるだけでなく、文体の一貫性を保ちながら、文章全体がつながるように、高度な言語処理がおこなわれます。

コンテナー型GPUクラウドサービス 高火力 DOK(ドック)

>>サービスの詳細を見る

LLM(大規模言語モデル)と生成AIの関係性

LLM(大規模言語モデル)と生成AIは混同されることが多いですが、その役割と機能には明確な違いがあります。

生成AIは、テキスト、画像、音声、動画など、さまざまな形式のデータを自律的に生成できるAI技術の総称です。たとえば、Stable DiffusionやMidjourneyなどの画像生成AI、あるいは音声合成AIなども生成AIの一種です。

一方、LLMは生成AIの一種であり、特に自然言語処理に特化したモデルです。LLMは、大量のテキストデータを学習することで、人間の言語を理解し、文章を生成、翻訳、要約、質疑応答など、さまざまな言語処理タスクを実行できます。つまり、LLMは生成AIという大きな枠組みの中の一要素として位置づけられ、とくに言語処理に関する高度な能力を持つ専門的なモデルとして機能しています。

言い換えれば、生成AIが「創作活動全般を支援できるアーティスト集団」だとすれば、LLMは「その中でとくに文章作成に長けた専門家」といえるでしょう。

LLM(大規模言語モデル)の種類

現在、さまざまな企業や研究機関によって多様なLLMが開発されています。以下に、代表的な9つのモデルとその特徴を紹介します。

| モデル名 | 開発企業 | 発表年 | パラメータ数 | おもな特徴 |

| BERT | 2018 | 3.4億 | 双方向の文脈理解が可能な初期の言語モデル | |

| GPT-3 | OpenAI | 2020 | 1,750億 | 汎用性の高い大規模言語モデル |

| LaMDA | 2021 | 1,370億 | 対話に特化した言語モデル | |

| PaLM | 2022 | 5,400億 | 効率的な言語処理が特徴のモデル | |

| GPT-4 | OpenAI | 2023 | 非公開 | マルチモーダル機能を備えた高性能モデル |

| LLaMa | Meta | 2023 | 70~700億 | オープンソースの軽量モデル |

| Claude | Anthropic | 2023 | 520億(推定) | 長文処理に優れたモデル |

| OpenCALM | サイバーエージェント | 2023 | 68億 | 日本語に特化したモデル |

| Alpaca 7B | スタンフォード大学 | 2023 | 70億 | 学術研究向けのモデル |

BERT

BERTは、Googleが2018年に発表した画期的な言語モデルです。Bidirectional Encoder Representations from Transformersの略称で、初めて「双方向のエンコード表現」を実現しました。

BERTの革新的な点は、文章を前後の文脈から同時に理解できる双方向性にあります。従来のモデルが文章を一方向(左から右)にのみ理解していたのに対し、BERTは文章全体の前後の文脈を考慮して各単語の意味を理解できます。たとえば「バスに乗る」と「低気圧に乗る」の「乗る」の意味の違いを、周囲の文脈から適切に理解できます。

このモデルは、翻訳や質問応答などの自然言語処理タスクで高い性能を発揮し、現代のLLMの発展に大きな影響を与えました。

GPT-3

GPT-3は、OpenAIが開発した大規模言語モデルで、GPT(Generative Pre-trained Transformer)シリーズの第3世代モデルとして開発されました。2020年に発表された当時、1,750億ものパラメータを持つモデルとして大きな注目を集めました。

GPT-3の特筆すべき点は、事前学習とファインチューニングを組み合わせた2段階の学習方式にあります。まず、膨大なテキストデータを学習すること、文法や単語の意味を理解します。その後、特定のタスクに合わせたデータをファインチューニングすることで、より精度の高い文章生成や翻訳、質問応答などが可能になります。この柔軟性が、GPT-3の大きな特徴である「汎用性」につながっています。たとえば、文章の作成だけでなく、コード生成や翻訳など、さまざまなタスクに対応できます。現在広く知られているChatGPTは、このGPT-3をベースに開発された対話型AIであり、人間との自然な会話を目指してファインチューニングされています。

GPT-4

GPT-4は、2023年にOpenAIが発表したGPTシリーズの最新世代の言語モデルです。具体的なパラメータ数は非公開ですが、前モデルであるGPT-3の1,750億を大きく上回る規模であると推測されています。

GPT-4の最大の特徴は、マルチモーダル機能の実装です。テキストだけでなく、画像も入力として受け付けることができ、画像の内容を理解した上で自然な文章を生成できます。たとえば、図表やグラフを読み取って解説したり、写真の状況を詳細に説明したりすることが可能です。また、GPT-3と比較して、より長い文脈を理解し、より複雑な推論や創造的なタスクをこなせるようになりました。

LaMDA

LaMDA(Language Model for Dialogue Applications)は、Googleが2021年に発表した対話特化型の大規模言語モデルです。1,370億のパラメータを持ち、1兆5,600億語のテキストデータで事前学習されているため、自然な対話を生成できることが特徴です。

従来のモデルが単に質問に答えるだけだったのに対し、LaMDAは文脈を維持しながら関連する話題を展開したり、適切なフォローアップ質問をおこなったりできます。これにより、より人間らしい、意味のある対話を実現しています。また、回答の根拠となる情報源を示すことで、信頼性の高い対話を実現している点も特徴です。

PaLM

PaLM(Pathways Language Model)は、Googleが2022年に発表した5,400億パラメータを持つ大規模言語モデルです。効率的な言語処理と高い推論能力が特徴です。

PaLMの革新的な点は、「Pathways」と呼ばれる新しい学習アーキテクチャを採用したことです。これにより、複数のタスクを同時に学習し、その知識をことなるタスクに転用することが可能になりました。具体的には、ある言語で学習した内容を別の言語に応用したり、論理的推論を必要とする問題解決に活用したり、数学的問題を解いたり、コードの生成をしたりと、高い性能を発揮します。

LLaMa

LLaMa(Large Language Model Meta AI)は、Meta社が2023年に発表したオープンソースの大規模言語モデルです。70億、130億、700億の3種類のパラメータを持つ規模のモデルが提供されています。そのなかでも、比較的少ないパラメータ数でGPT-3に匹敵する性能を実現していることが注目されています。

LLaMaが優れた性能を実現できたのは、効率的な学習アルゴリズムと、厳選された高品質なトレーニングデータの活用によるものです。また、オープンソースで提供されているため、研究者やデベロッパーはLLaMaを目的に合わせて自由にカスタマイズし、さまざまな分野で活用できる点も大きな特徴です。

Claude

Claudeは、Anthropicが2023年に発表した推測520億パラメータを持つ大規模言語モデルです。OpenAIの元エンジニアたちによって開発されました。

Claudeの最大の特徴は、一度に処理できる文字数(トークン数)の多さです。10万トークン以上の長文を処理できるため、学術論文や長大な文書の分析、要約に特に優れています。また、倫理的な考慮事項に重点を置いた設計がなされており、より安全で信頼性の高い応答を生成することを目指しています。

OpenCALM

OpenCALMは、サイバーエージェントが2023年に公開した、日本語特化型の言語モデルです。約68億のパラメータを持ちます。

日本語に特化して開発されたOpenCALMの特徴は、日本語特有の言語構造や文化的なニュアンスを深く理解できる点です。特定のユースケースに特化せず、汎用的な用途に使えるよう設計されており、日本企業のビジネスニーズに応えやすい構成となっています。また、オープンソースで公開されており、日本のAI技術の発展に貢献することを目指しています。

Alpaca 7B

Alpaca 7Bは、スタンフォード大学が2023年に発表した、約70億のパラメータを持つ学術研究向けの言語モデルです。

Alpaca 7Bの特徴は、Meta社のLLaMaをベースに、指示実行(Instruction-following)に特化してファインチューニングを施している点です。比較的小規模なパラメータ数でありながら、与えられた指示に従って的確なタスクを実行できる能力を持ちます。学術目的での利用に限定して公開されており、AI研究の発展に重要な役割を果たしています。

AI・ディープラーニングに最適な高火力GPUサーバー

>>サービスの詳細を見る

LLM(大規模言語モデル)の活用例とメリット

LLMは、高度な言語解析と生成能力を備え、ビジネスから教育まで幅広い分野で革新的な活用が進んでいます。とくに、カスタマーサポート、コンテンツ作成、多言語翻訳、プログラミング支援の4つの分野で注目されています。

これらの分野において、LLMは業務効率の向上、コスト削減、サービス品質の改善など、具体的な成果が報告されています。以下では、各分野における具体的な活用方法とそのメリットについてくわしく解説します。

テキストベースのカスタマーサポート

LLMを活用したカスタマーサポートは、24時間365日の顧客対応を可能にし、企業のサポート体制を大きく変革しています。

このシステムでは、過去の問い合わせデータや製品マニュアル、FAQなどを事前に学習させることで、顧客からの質問に対して、的確な回答が可能になります。たとえば、「製品の返品方法について教えてください」という問い合わせに対して、具体的な返品手順やポリシーを即座に提示できます。

また、回答の精度向上のため、以下のような特徴が実装されています。

- 文脈を考慮した会話の継続

- 必要に応じた追加質問による情報の明確化

- 専門用語の平易な言葉への言い換え

このシステムの導入により、以下のようなメリットが得られています。

- 応答待ち時間の大幅削減

- サポートスタッフの作業負荷軽減

- 24時間対応による顧客満足度の向上

- 問い合わせ対応の品質の標準化

記事コンテンツの作成・校正

LLMは、記事作成から校正まで、コンテンツ制作プロセス全体をサポートする強力なツールとなっています。

記事生成においては、与えられたテーマに基づいて、構造化された文章を作成できます。たとえば、「環境に優しい生活習慣」というテーマに対して、具体的な実践方法や科学的根拠、統計データなどを盛り込んだ記事を生成可能です。また、特定のトーンや文体といった細かい指示にも対応できます。

コンテンツの品質向上においては、以下のような機能を提供します。

- 文法エラーの検出と修正

- 冗長な表現の改善提案

- 一貫性のチェック

- SEO最適化のための提案

これらの機能により、以下のようなメリットが得られています。

- コンテンツ制作時間の短縮

- 品質の均一化

- 制作コストの削減

- クリエイターの創造的作業への注力が可能

文章のリアルタイム翻訳

LLMによる翻訳は、文脈を考慮した自然な多言語翻訳を実現し、グローバルコミュニケーションを変革しています。

従来の機械翻訳と異なり、LLMは文章全体の文脈を包括的に把握した上で翻訳をおこないます。たとえば、「apple」という単語が出てきた場合、前後の文脈から「果物のりんご」なのか「企業名のApple」なのかを適切に判断し、翻訳することができます。

具体的な特徴として、以下が挙げられます。

- 業界固有の専門用語への対応

- 文化的な違いを考慮した意訳

- 口語と文語の適切な使い分け

- リアルタイムでの翻訳処理

これにより、以下のようなメリットが実現されています。

- グローバルビジネスのコミュニケーション効率化

- 翻訳コストの削減

- 多言語コンテンツの迅速な展開

- 異文化間の円滑なコミュニケーション

コーディングやバグの検出

LLMは、プログラミング分野において、コード生成、バグ検出、コードレビューの3つの主要機能を提供し、開発効率を大きく向上させています。

コード生成機能では、自然言語による要件記述から実際のプログラムコードを自動生成できます。たとえば、「ユーザー入力を検証するフォームを作成したい」という要望に対して、適切なバリデーション処理を含むコードを提案します。

おもな機能は以下の通りです。

- 複数のプログラミング言語に対応したコード生成

- セキュリティを考慮したコード提案

- 最新のベストプラクティスに基づく実装

- APIやライブラリの使用例の提示

これらの機能により、以下のようなメリットが得られています。

- 開発時間の短縮

- コードの品質向上

- セキュリティリスクの低減

- 開発者の学習効率の向上

コンテナー型GPUクラウドサービス 高火力 DOK(ドック)

>>サービスの詳細を見る

LLM(大規模言語モデル)の課題

大規模言語モデルは革新的な技術である一方で、いくつかの重要な課題も抱えています。現在、LLMには以下のような課題が存在します。

- ハルシネーション(幻覚)現象

- データバイアスの問題

- 著作権に関する法的課題

- プロンプトインジェクションのリスク

- 計算資源とコストの問題

- プライバシーとデータセキュリティ

ハルシネーション(幻覚)は、LLMが事実と異なる情報や存在しない情報を生成してしまう現象です。たとえば、実在しない研究論文を引用したり、架空の製品仕様を詳細に説明したりすることがあります。この問題は、モデルの学習方法や構造に起因しており、完全な解決は現時点では困難とされています。そのため、ユーザーは出力された情報を必ず検証する必要があるのです。

データバイアスの問題は、学習データに含まれる偏りがモデルの出力に影響を与えることを指します。たとえば、特定の文化や視点に偏ったデータで学習すると、その偏りが反映された回答を生成する可能性があります。この課題に対しては、多様なデータソースの活用や、バイアス検出・軽減のための技術開発が進められています。

著作権に関する法的課題は、LLMが学習データとして使用する情報の著作権問題と、生成されたコンテンツの権利帰属の問題の両面があります。とくに生成されたコンテンツを商用利用する際の法的な扱いについては、まだ明確な基準が十分に確立されていません。

プロンプトインジェクションは、悪意のある入力によってLLMを誤動作させたり、機密情報を漏洩させたりする攻撃手法です。この問題は、とくに企業におけるLLMの利用において深刻なセキュリティリスクとなっています。対策としては、入力内容の厳格な検証や、出力結果のフィルタリング、定期的なセキュリティ監査などが実施されています。

計算資源とコストの問題は、LLMの学習や運用に膨大な計算資源が必要となり、高額なコストが発生する問題です。とくに大規模なモデルでは、GPUなどのハードウェアの調達や電力消費が大きな負担となっています。この問題に対しては、モデルの軽量化や効率的な学習アルゴリズムの開発が進められています。

プライバシーとデータセキュリティの課題は、LLMへの学習データや入力データに含まれる個人情報の保護に関する問題です。とくに医療や金融など、機密性の高い情報を扱う分野での利用には慎重な対応が必要です。これに対しては、データの匿名化技術の開発や、オンプレミス型の導入など、さまざまなアプローチが検討されています。

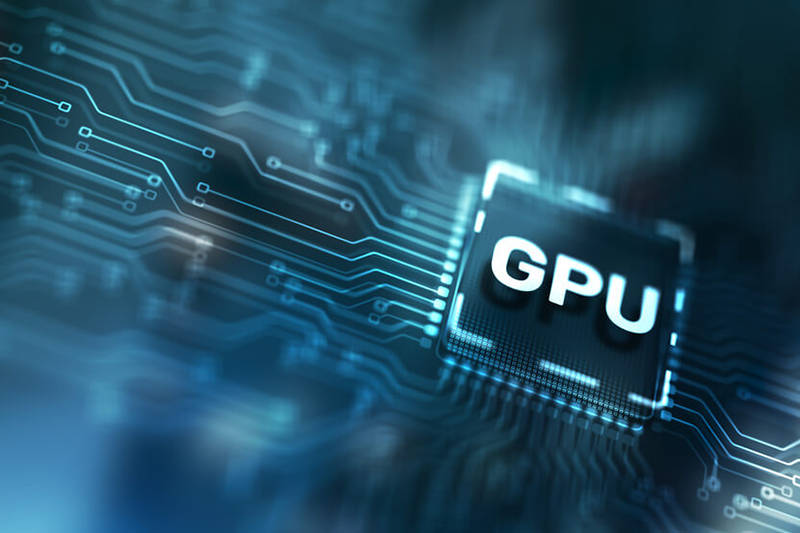

LLMのトレーニングには高性能なGPUが必要

LLMのトレーニングと運用には、膨大な計算処理能力が必要とされ、高性能なGPUの存在が不可欠です。LLMの学習処理では、数千億のパラメータを同時に処理する必要があり、従来のCPUでは学習に非常に長い時間がかかります。GPUの並列処理能力を活用することで、学習時間を大幅に短縮し、効率的なモデルの開発が可能となります。

最新のGPU技術では、メモリ管理の効率化が進んでおり、大規模な言語モデルの学習に適した環境を提供しています。たとえば、NVIDIA H100は大容量メモリを搭載し、従来のGPUと比較して大幅な性能向上を実現しています。また、複数のGPUを効率的に連携させる分散学習技術や、メモリ使用量を最適化する量子化技術など、より効率的なトレーニングを可能にする技術開発も進んでいます。

このような高性能GPUを利用できるサービスとして、さくらインターネットでは「高火力 DOK」を提供しています。高火力 DOKは、最新のGPUを搭載した高性能な計算資源をコンテナー型クラウドとして提供し、必要な時に必要な分だけGPUリソースを利用することができます。秒単位の従量課金制を採用しており、初期費用なしで利用できる点が特徴です。また、日本国内でのデータ保管により、セキュリティ面でも安心して利用できる環境を実現しています。

まとめ

LLMは、膨大なテキストデータと深層学習技術を活用し、自然言語を深く解析し生成できる革新的な技術です。従来の言語モデルと比較して、データ量、計算量、パラメータ量を飛躍的に増加させることで、より人間らしい自然な言語解析と生成を実現しています。

LLMの処理は、テキストの単語や文字などのトークンに分割し、数値に変換する前処理から始まります。その後、ニューラルネットワークを用いて大量のデータを学習し、文脈を処理することで、さまざまな自然言語処理タスクを実行します。この技術は、カスタマーサポート、コンテンツ作成、多言語翻訳、プログラミング支援など、幅広い分野で活用されており、ビジネスプロセスの効率化に大きく貢献しています。

一方で、ハルシネーション(幻覚)やプロンプトインジェクション、著作権問題、プライバシーとデータセキュリティなど、いくつかの重要な課題も抱えています。また、LLMの開発・運用には高性能なGPUなどの計算資源とコストの面での課題もあります。

今後、これらの課題に対する技術的な改善や法整備が進むことで、LLMの活用範囲はさらに広がることが期待されます。企業がLLMを導入する際は、これらの課題を十分に認識し、適切なリスク管理と倫理的なガイドラインに基づいて活用することが重要です。

コンテナー型GPUクラウドサービス 高火力 DOK(ドック)

>>サービスの詳細を見る

さくらインターネットが提供している高火力シリーズ「PHY」「VRT」「DOK」を横断的に紹介する資料です。お客様の課題に合わせて最適なサービスを選んでいただけるよう、それぞれのサービスの特色の紹介や、比較表を掲載しています。

New

New

New

New

New

New

特集

特集